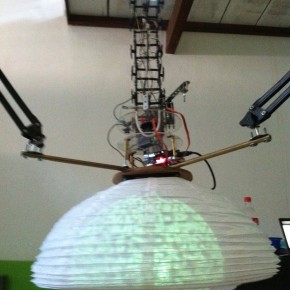

No sábado, dia 25 de fevereiro, nos reunimos para testar as novas interações do Hiperorganismo que vai ser exposto no evento VIVO ARTE.MOV entre 29 de fevereiro e 2 de março de 2012. A meta era aplicar três interações: o movimento do pescoço do robô deveria seguir o interator, de acordo com o reconhecimento de rosto; a visualização da aproximação do interator que deveria ser projetada na barriga do robô e a sonoridade do robô também de acordo com a aproximação do interator.

O Robô possui duas entradas de dados, uma referente ao sensor de aproximação, que fornece os dados para a visualização e sonorização do robô. A outra referente que são as imagens capturadas na câmera – o olho do robô – que permite o reconhecimento de faces no OpenCV. Usamos dois computadores para realizar tudo. O principal que recebe e envia os dados para o Arduino, e processa a imagem para o reconhecimento de faces, este só envia os dados de aproximação via OSC para o o segundo computador que gera a visualização e que também está conectado ao projetor interno do robô.

Ao longo do dia cada um foi ajustando a sua parte. A visualização desenvolvida no Processing por Barbara Castro, por exemplo, teve de aumentar o tamanho das partículas e selecionar apenas a cor verde, pois dava mais contraste em um ambiente que não está completamente escuro, como deve ser o da exposição. Testamos uma variação linear e uma radial de disposição das partículas, a primeira faria uma faixa de luz em volta da lanterna japonesa, a segunda (selecionada) forma um círculo. O recuo das partículas parecia muito acelerado, porém quando testamos com o som desenvolvido no Pure Data pela mexicana Leslie Garcia que combinou, mesmo assim ainda faltam pequenos ajustes.